Procesele

Markov au fost dezvoltate de oamenii de știință în 1907. Matematicieni de frunte din acea vreme au dezvoltat această teorie, unii dintre ei încă o îmbunătățesc. Acest sistem se extinde și în alte domenii științifice. Lanțurile Markov practice sunt folosite în diverse domenii în care o persoană trebuie să ajungă într-o stare de așteptare. Dar pentru a înțelege clar sistemul, trebuie să cunoașteți termenii și prevederile. Aleatoritatea este considerată a fi principalul factor care determină procesul Markov. Adevărat, nu seamănă cu conceptul de incertitudine. Are anumite condiții și variabile.

Caracteristici ale factorului aleatoriu

Această condiție este supusă stabilității statice, mai precis, regularităților sale, care nu sunt luate în considerare în caz de incertitudine. La rândul său, acest criteriu permite utilizarea metodelor matematice în teoria proceselor Markov, după cum a observat un om de știință care a studiat dinamica probabilităților. Lucrarea pe care a creat-o s-a ocupat direct de aceste variabile. La rândul său, procesul aleator studiat și dezvoltat, care are conceptele de stare șitranziție, precum și utilizat în probleme stocastice și matematice, permițând în același timp funcționarea acestor modele. Printre altele, oferă o oportunitate de a îmbunătăți alte științe aplicate teoretice și practice importante:

- teoria difuziei;

- teoria coadă;

- teoria fiabilității și alte lucruri;

- chimie;

- fizică;

- mecanici.

Caracteristici esențiale ale unui factor neplanificat

Acest proces Markov este condus de o funcție aleatorie, adică orice valoare a argumentului este considerată o valoare dată sau una care ia o formă pre-preparată. Exemplele sunt:

- oscilații în circuit;

- viteză de mișcare;

- rugozitatea suprafeței într-o anumită zonă.

Se crede, de asemenea, că timpul este un fapt al unei funcții aleatorii, adică are loc indexarea. O clasificare are forma unei stări și a unui argument. Acest proces poate fi atât cu stări sau timp discret, cât și continuu. Mai mult, cazurile sunt diferite: totul se întâmplă fie într-o formă, fie sub altă formă, fie simultan.

Analiza detaliată a conceptului de aleatorie

A fost destul de dificil să construiești un model matematic cu indicatorii de performanță necesari într-o formă clar analitică. În viitor, a devenit posibilă realizarea acestei sarcini, deoarece a apărut un proces aleatoriu Markov. Analizând acest concept în detaliu, este necesar să se derivă o anumită teoremă. Un proces Markov este un sistem fizic care și-a schimbatpoziție și stare care nu au fost preprogramate. Astfel, se dovedește că în el are loc un proces aleatoriu. De exemplu: o orbită spațială și o navă care este lansată în ea. Rezultatul a fost atins doar din cauza unor inexactități și ajustări, fără de care modul specificat nu este implementat. Majoritatea proceselor în curs sunt inerente aleatorii, incertitudinii.

În fond, aproape orice opțiune care poate fi luată în considerare va fi supusă acestui factor. Un avion, un dispozitiv tehnic, o sală de mese, un ceas - toate acestea sunt supuse unor modificări aleatorii. Mai mult, această funcție este inerentă oricărui proces aflat în desfășurare în lumea reală. Cu toate acestea, atâta timp cât acest lucru nu se aplică parametrilor reglați individual, perturbațiile care apar sunt percepute ca deterministe.

Conceptul unui proces stocastic Markov

Proiectând orice dispozitiv tehnic sau mecanic, dispozitivul obligă creatorul să țină cont de diverși factori, în special de incertitudini. Calculul fluctuațiilor și perturbațiilor aleatoare apare în momentul de interes personal, de exemplu, la implementarea unui pilot automat. Unele dintre procesele studiate în științe precum fizica și mecanica sunt.

Dar acordarea atenției acestora și efectuarea unor cercetări riguroase ar trebui să înceapă în momentul în care este direct nevoie. Un proces aleatoriu Markov are următoarea definiție: caracteristica probabilității formei viitoare depinde de starea în care se află la un moment dat și nu are nimic de-a face cu modul în care arăta sistemul. Deci datconceptul indică faptul că rezultatul poate fi prezis, luând în considerare doar probabilitatea și uitând de fundal.

Explicație detaliată a conceptului

În acest moment, sistemul se află într-o anumită stare, se mișcă și se schimbă, practic este imposibil de prezis ce se va întâmpla în continuare. Dar, având în vedere probabilitatea, putem spune că procesul va fi finalizat într-o anumită formă sau o reține pe cea anterioară. Adică viitorul se naște din prezent, uitând de trecut. Când un sistem sau un proces intră într-o stare nouă, istoricul este de obicei omis. Probabilitatea joacă un rol important în procesele Markov.

De exemplu, contorul Geiger arată numărul de particule, care depinde de un anumit indicator, și nu de momentul exact în care a venit. Aici criteriul principal este cel de mai sus. În aplicarea practică, pot fi luate în considerare nu numai procesele Markov, ci și altele similare, de exemplu: aeronavele participă la bătălia sistemului, fiecare dintre acestea fiind indicată de o anumită culoare. În acest caz, criteriul principal este din nou probabilitatea. În ce moment va apărea preponderența în numere și pentru ce culoare nu este cunoscută. Adică, acest factor depinde de starea sistemului și nu de succesiunea deceselor aeronavelor.

Analiza structurală a proceselor

Un proces Markov este orice stare a unui sistem fără o consecință probabilistică și fără a ține cont de istorie. Adică dacă includeți viitorul în prezent și omiteți trecutul. Suprasaturarea acestui timp cu preistorie va duce la multidimensionalitate șiva afișa construcții complexe de circuite. Prin urmare, este mai bine să studiați aceste sisteme cu circuite simple cu parametri numerici minimi. Drept urmare, aceste variabile sunt considerate determinante și condiționate de unii factori.

Un exemplu de procese Markov: un dispozitiv tehnic funcțional care este în stare bună în acest moment. În această stare de lucruri, ceea ce interesează este probabilitatea ca dispozitivul să funcționeze pentru o perioadă lungă de timp. Dar dacă percepem echipamentul ca fiind depanat, atunci această opțiune nu va mai aparține procesului luat în considerare din cauza faptului că nu există informații despre cât timp a funcționat dispozitivul înainte și dacă au fost efectuate reparații. Totuși, dacă aceste două variabile de timp sunt suplimentate și incluse în sistem, atunci starea acestuia poate fi atribuită lui Markov.

Descrierea stării discrete și a continuității timpului

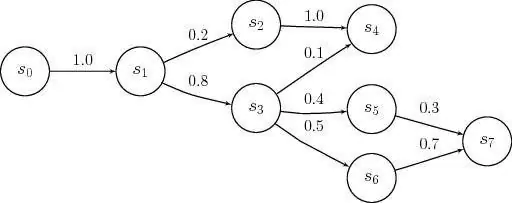

Modelele procesului

Markov sunt aplicate în momentul în care este necesară neglijarea preistoriei. Pentru cercetare în practică, cel mai des sunt întâlnite stări discrete, continue. Exemple de astfel de situații sunt: structura echipamentului include noduri care pot eșua în timpul orelor de lucru, iar acest lucru se întâmplă ca o acțiune neplanificată, aleatorie. Ca urmare, starea sistemului suferă reparații ale unuia sau altuia element, în acest moment unul dintre ele va fi sănătos sau ambele vor fi depanate, sau invers, sunt complet ajustate.

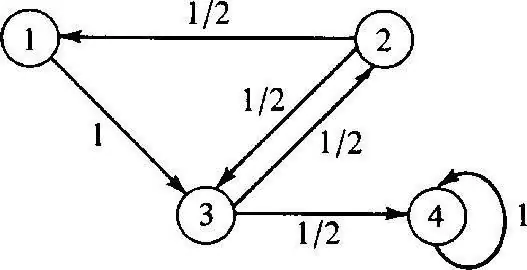

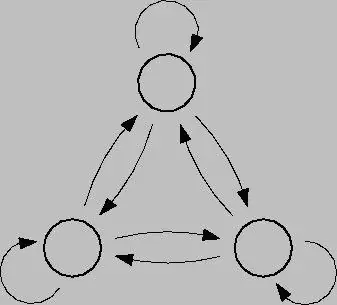

Procesul Markov discret se bazează pe teoria probabilității și este, de asemeneatrecerea sistemului de la o stare la alta. Mai mult, acest factor apare instantaneu, chiar dacă apar avarii accidentale și lucrări de reparații. Pentru a analiza un astfel de proces, este mai bine să folosiți grafice de stare, adică diagrame geometrice. Stările sistemului în acest caz sunt indicate prin diferite forme: triunghiuri, dreptunghiuri, puncte, săgeți.

Modelarea acestui proces

Procesele Markov în stare discretă sunt posibile modificări ale sistemelor ca urmare a unei tranziții instantanee și care pot fi numerotate. De exemplu, puteți construi un grafic de stare din săgeți pentru noduri, unde fiecare va indica calea factorilor de defecțiune direcționați diferit, starea de funcționare etc. În viitor, pot apărea orice întrebări: cum ar fi faptul că nu toate elementele geometrice indică în direcția corectă, deoarece în acest proces, fiecare nod se poate deteriora. Când lucrați, este important să luați în considerare închiderile.

Procesul Markov în timp continuu are loc atunci când datele nu sunt prefixate, se întâmplă aleatoriu. Tranzițiile nu au fost planificate anterior și au loc în s alturi, în orice moment. În acest caz, din nou, rolul principal îl joacă probabilitatea. Cu toate acestea, dacă situația actuală este una dintre cele de mai sus, atunci va fi necesar un model matematic pentru a o descrie, dar este important să înțelegem teoria posibilității.

Teorii probabiliste

Aceste teorii consideră probabilistice, având trăsături caracteristice precumordine aleatorie, mișcare și factori, probleme matematice, nu deterministe, care sunt certe din când în când. Un proces Markov controlat are și se bazează pe un factor de oportunitate. Mai mult, acest sistem poate trece instantaneu în orice stare în diferite condiții și intervale de timp.

Pentru a pune in practica aceasta teorie este necesar sa ai cunostinte importante despre probabilitate si aplicarea acesteia. În cele mai multe cazuri, cineva se află într-o stare de așteptare, care, în sens general, este teoria în cauză.

Exemple de teoria probabilității

Exemple de procese Markov în această situație pot fi:

- cafenea;

- casele de bilete;

- ateliere de reparații;

- stații pentru diverse scopuri etc.

De regulă, oamenii se ocupă de acest sistem în fiecare zi, astăzi se numește coadă. La unitățile în care este prezent un astfel de serviciu, este posibil să se solicite diverse solicitări, care sunt satisfăcute în proces.

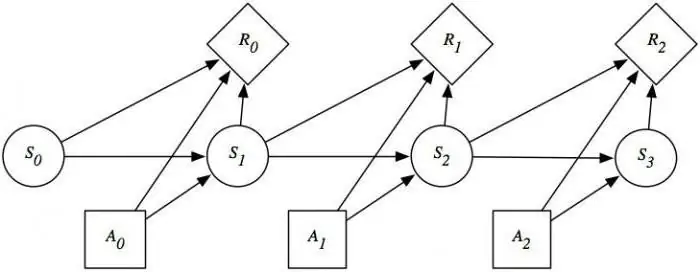

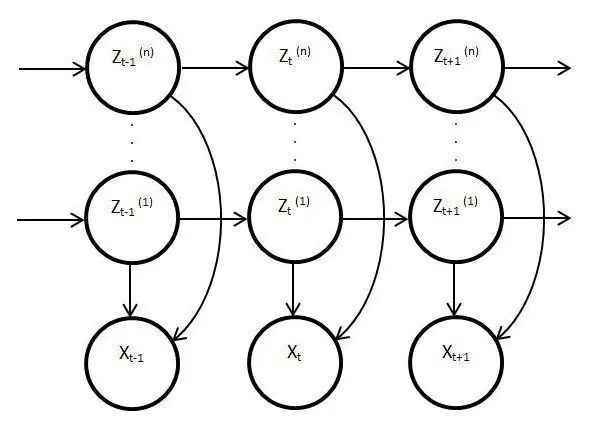

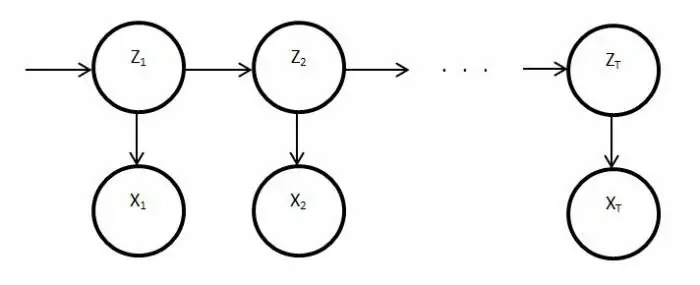

Modele de proces ascunse

Astfel de modele sunt statice și copiază munca procesului original. În acest caz, caracteristica principală este funcția de monitorizare a parametrilor necunoscuți care trebuie dezlegați. Ca urmare, aceste elemente pot fi folosite în analiză, practică sau pentru a recunoaște diferite obiecte. Procesele obișnuite Markov se bazează pe tranziții vizibile și pe probabilitate, doar necunoscute sunt observate în modelul latentvariabile afectate de stare.

Dezvăluirea esențială a modelelor Markov ascunse

De asemenea, are o distribuție de probabilitate printre alte valori, ca urmare, cercetătorul va vedea o secvență de caractere și stări. Fiecare acțiune are o distribuție de probabilitate între alte valori, astfel încât modelul latent oferă informații despre stările succesive generate. Primele note și referiri la ele au apărut la sfârșitul anilor șaizeci ai secolului trecut.

Apoi au fost folosite pentru recunoașterea vorbirii și ca analizatori de date biologice. În plus, modelele latente s-au răspândit în scris, mișcări, informatică. De asemenea, aceste elemente imită activitatea procesului principal și rămân statice, cu toate acestea, în ciuda acestui fapt, există trăsături mult mai distinctive. În special, acest fapt se referă la observarea directă și generarea de secvențe.

Procesul staționar Markov

Această condiție există pentru o funcție de tranziție omogenă, precum și pentru o distribuție staționară, care este considerată acțiunea principală și, prin definiție, aleatorie. Spațiul de fază pentru acest proces este o mulțime finită, dar în această stare de lucruri, diferențierea inițială există întotdeauna. Probabilitățile de tranziție în acest proces sunt luate în considerare în condiții de timp sau elemente suplimentare.

Studiul detaliat al modelelor și proceselor Markov relevă problema satisfacerii echilibrului în diferite domenii ale viețiiși activitățile societății. Având în vedere că această industrie afectează știința și serviciile de masă, situația poate fi corectată analizând și prezicând rezultatul oricăror evenimente sau acțiuni ale acelorași ceasuri sau echipamente defecte. Pentru a utiliza pe deplin capacitățile procesului Markov, merită să le înțelegeți în detaliu. La urma urmei, acest dispozitiv și-a găsit o aplicație largă nu numai în știință, ci și în jocuri. Acest sistem în forma sa pură nu este de obicei luat în considerare și, dacă este utilizat, atunci numai pe baza modelelor și schemelor de mai sus.